El pasado miércoles 21 de enero se realizó la jornada “IA, la humanidad frente al espejo: formación e investigación en Educación Superior” organizada por el Magíster en Didáctica, la Dirección de Relaciones Internacionales y la Coordinación de Inteligencia Artificial de la Facultad de Filosofía y Humanidades. Además, las actividades contaron con la participación de académicos de la Facultad de Comunicación e Imagen y la Facultad de Ciencias Físicas y Matemáticas de la Universidad de Chile.

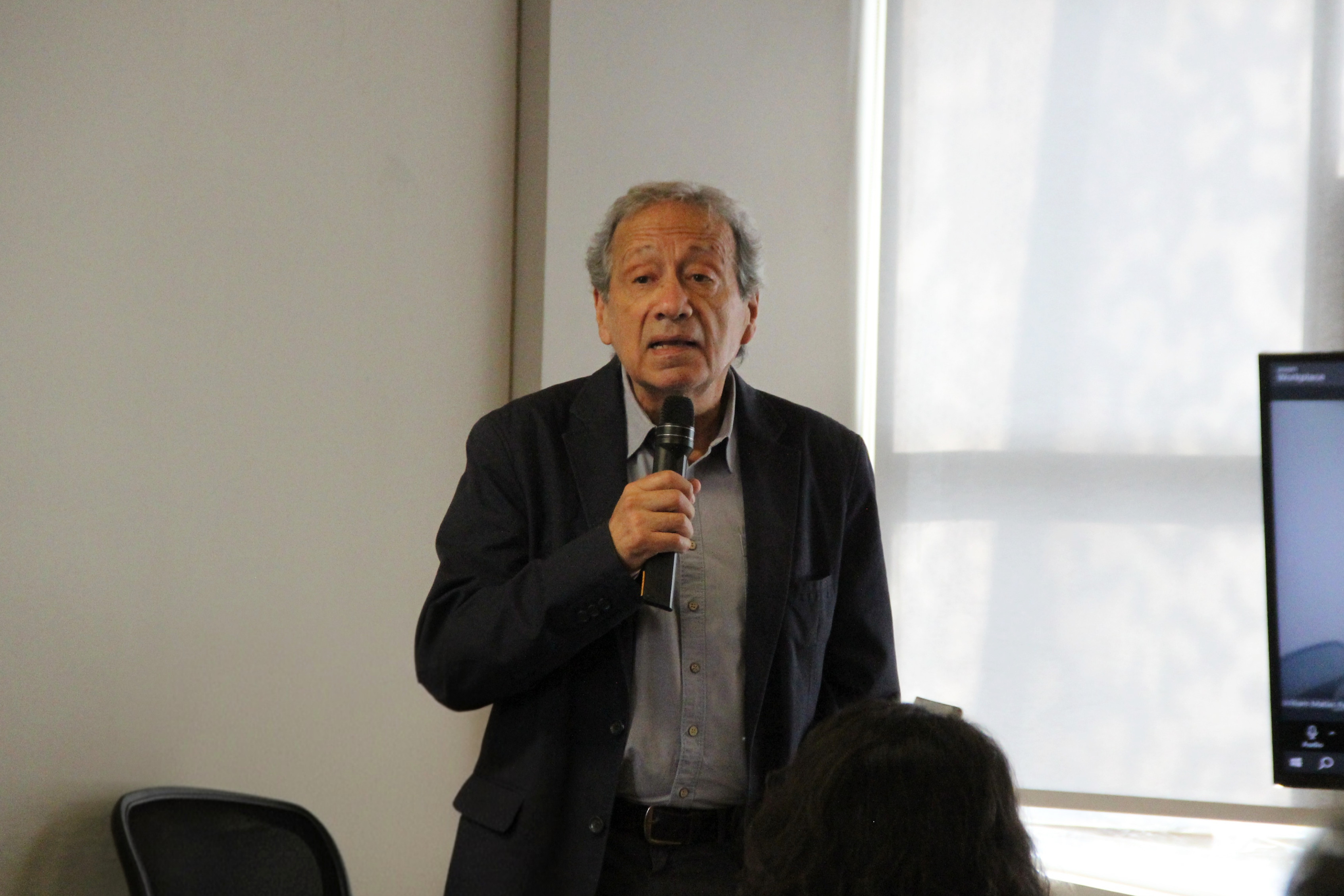

El decano Raúl Villarroel Soto abrió la jornada, enfatizando que la universidad tiene la obligación de enfrentar este fenómeno y esclarecer la misión de las humanidades frente al avance de la inteligencia artificial (IA): "tenemos que lidiar con una emergencia de un problema que no estaba dentro de nuestros planes y tenemos que tener la capacidad de responder adecuadamente en función de nuestras capacidades". Para esto, señaló que "desde 2025 hemos impulsado un proyecto con un equipo muy interesante de aproximadamente quince personas de nuestra facultad para administrar un fenómeno que nos supera".

IA: un espejo de nosotros mismos

La jornada comenzó con la conferencia magistral “IA: un espejo de nosotros mismos: desde la colaboración creativa hasta el riesgo de la manipulación” del Dr. Marcelo Pustilnik, profesor de la Universidad Federal de Santa Maria (Brasil). Aquí planteó que la IA “es fundamentalmente un espejo y eso define tanto su mayor potencial como su mayor riesgo”.

Dentro de sus puntos positivos, explicó que esta tecnología permite una colaboración creativa similar a un “partido de ping-pong”, donde el humano aporta la intuición y la máquina los patrones de información. Sin embargo, advirtió que su mayor peligro es la pérdida de autenticidad y pensamiento crítico, convirtiéndose “en el espejo perfecto para nuestros propios prejuicios, creando una burbuja de realidad tan cómoda y convincente que dejamos de cuestionar”.

Para mitigar la manipulación de la realidad de parte de la IA, el académico propuso un "kit de higiene mental" basado en tres pilares: cuestionar las fuentes, consumir contenidos no filtrados por algoritmos, como libros físicos o museos, y fortalecer la “red humana”, sobre todo con personas que piensen distinto. “La mejor defensa frente a la inteligencia artificial es nuestra propia inteligencia natural, emocional y colectiva”, concluyó Marcelo Pustilnik.

Panel transdisciplinar

El panel de conversación, moderado por el profesor Francisco Herrera Jeldres del Departamento de Filosofía, analizó el impacto de la IA desde la comunicación, la ética y la educación. Este panel estuvo conformado por Claudio Gutiérrez Gallardo del Departamento de Ciencias de la Computación de FCFM, Carlos Ossa Swears y Patricia Peña Miranda de FCEI.

Carlos Ossa se centró en los conceptos de simulación, agencia y proceso, considerando que la realidad se ha datificado y que la simulación ya no es solo lo "falso", sino un nuevo estado de lo real controlado por poderes corporativos. Además, advirtió sobre el peligro de que la academia pierda su esencia crítica y autenticidad: “una demanda radical para el pensamiento y la investigación universitaria es que ya no podemos pensar que la simulación es básicamente la producción de lo falso, sino de otro estado de lo real que todavía no podemos imaginar”.

Por su parte, Claudio Gutiérrez, señaló que estas máquinas tocan por primera vez la esencia humana del pensamiento y el lenguaje. Planteó el desafío para la educación masiva, donde la IA puede simular lecciones y respuestas de manera más eficiente que los métodos tradicionales, obligando a repensar la tarea docente.

Finalmente, la profesora Patricia Peña aportó una mirada crítica sobre la economía política de estas tecnologías, impulsadas por un puñado de empresas de Silicon Valley y entrenadas con datos, incluyendo biométricos, sin consentimiento ético. Enfatizó que los modelos de lenguaje están diseñados para dar respuestas siempre, incluso si deben mentir, reproduciendo sesgos masculinos y anglosajones. Explicó que también existen tecnodiversidades que pueden funcionar como una alternativa interesante, mediante el desarrollo de modelos de IA más pequeños y éticos, pero que deben ser incentivados con una ética que tenga en mente el consentimiento como clave fundamental.

La jornada finalizó con grupos de discusión entre los asistentes, donde se abordó la necesidad de una autorreflexión crítica sobre los procesos de virtualización y se propusieron modalidades de experimentación comunitaria. En estos espacios se destacó la importancia de sensibilizar a la comunidad universitaria ante estas transformaciones, promoviendo la autoconciencia y el compromiso ético-político frente al uso de grandes modelos de lenguaje y sus implicancias en la producción de conocimiento.

.jpeg.jpeg)